Table of contents

Open Table of contents

1. Tokenization

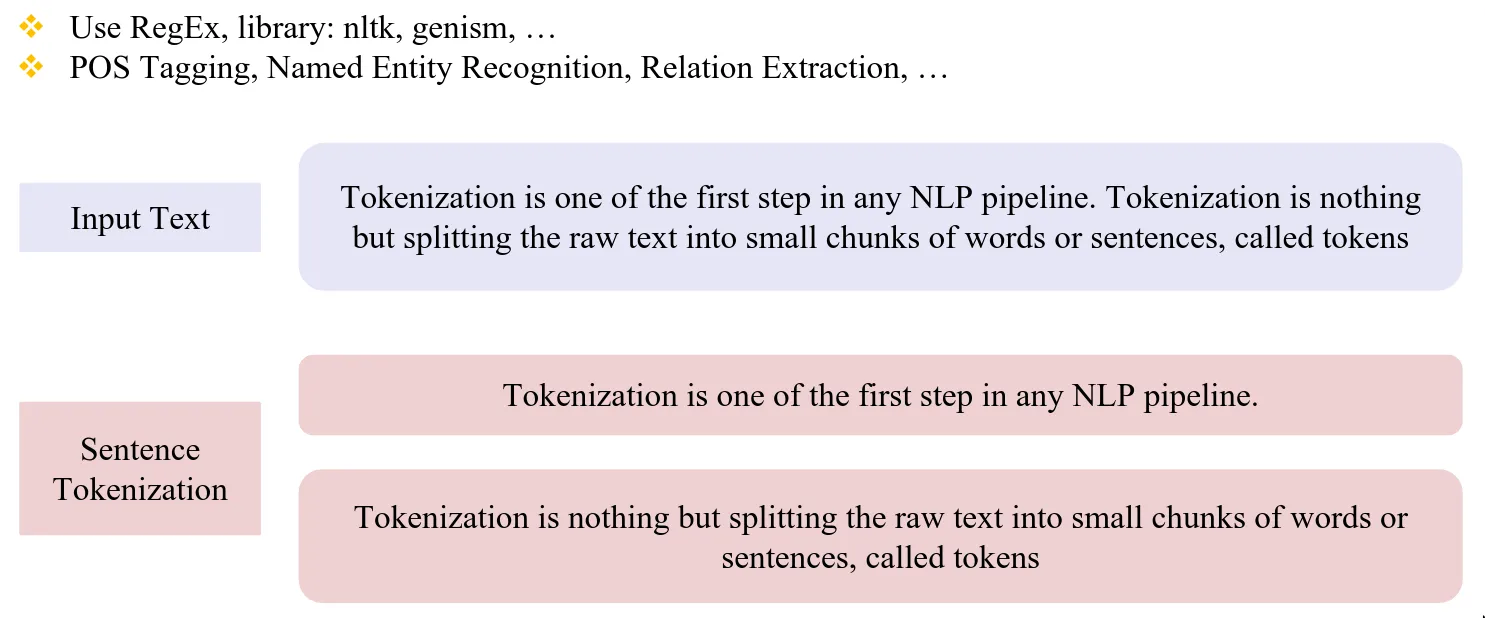

1.1. Sentence Tokenization

Mục tiêu là chia các văn bản, đoạn văn bản thành câu.

1.2. Word Tokenization

| Word-based | Character-based |

|---|---|

| Kích thước vocab lớn | Kích thước vocab là bảng chữ cái cho nên rất nhỏ |

| Mất mối liên hệ giữa các từ cùng nhóm (vd: run, running, runner) | Các token không mang nhiều ý nghĩa |

-> Tìm kiếm phương pháp vẫn giữ được đặc trưng của 2 phương pháp trên: subword-based tokenization

2. Subword-based tokenization

- 3 alogrithms phổ biến:

- Byte-Pair Encoding

- Unigram language modeling tokenization

- WordPiece

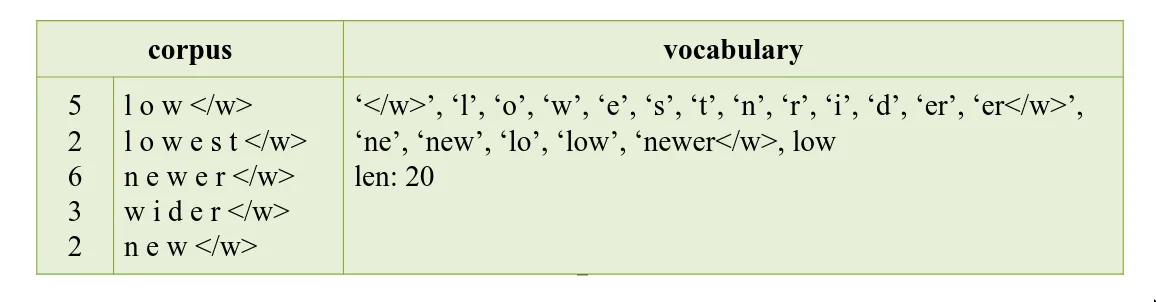

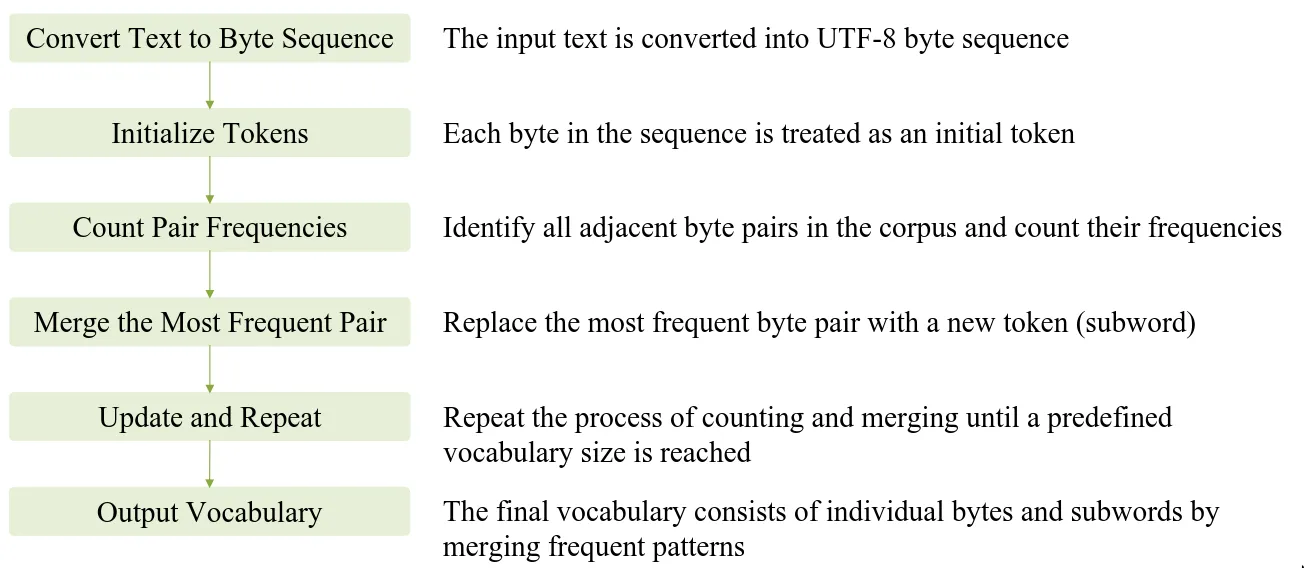

2.1. Byte-Pair encoding

Ý tưởng:

- Chia những corpus thành từng chuỗi kí tự

- Dựa trên những cặp kí tự xuất hiện nhiều để gộp lại.

- Lặp lại bước trên đến khi số lần xuất hiện của các cặp kí tự là 1.

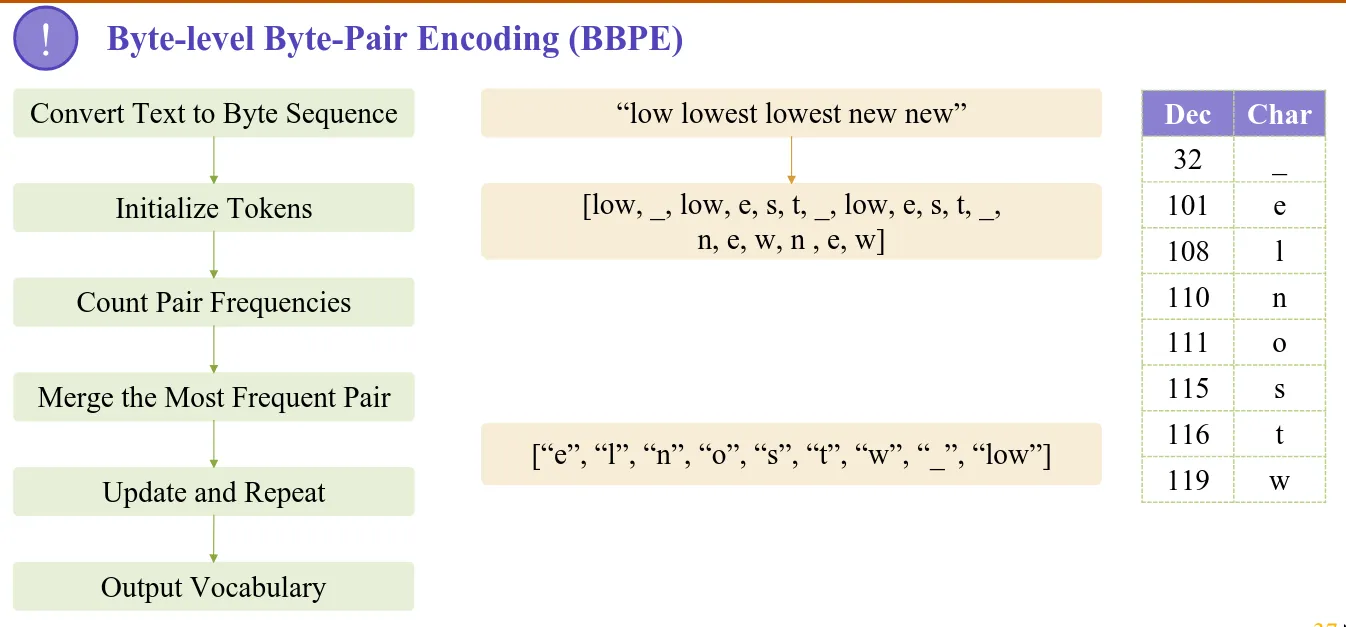

2.1.1. Byte-level Byte-Pair encoding.

Thay vì tách mỗi chuỗi corpus thành các kí tự thì đoạn text đầu vào sẽ được chuyển đổi sang dạng UTF-8.

3. Machine Translating

Việc dịch từ source language(input) sang target language(output) thuộc về bài toán optimization:

Yêu cầu 2 thành phần:

- Một hàm học để tính ra giá trị của

- Một hàm decode để tính toán tốt nhất

3.1. Byte Latent Transformer

- Thay vì chia đoạn văn bản thành các tokens thì chia trực tiếp thành các chuỗi bytes.

- Xây dựng chuỗi bytes dựa trên entropy

∞. Câu hỏi

- BPE hay BPPE được xài thuờng xuyên hơn?